Chain-of-thought Prompting Elicits Reasoning In Large Language Models

Stell dir vor, dein Papagei kann plötzlich komplizierte Matheaufgaben lösen. Nicht einfach nur "Wer ist der Schönste im ganzen Land?", sondern echte Probleme! Das ist ungefähr das, was gerade in der Welt der künstlichen Intelligenz passiert – dank einer cleveren Technik namens Chain-of-Thought Prompting.

Die sprechenden Superhirne von Morgen (Heute?)

Wir alle kennen diese großen Sprachmodelle, die uns beim Texten helfen, E-Mails verfassen oder sogar Gedichte schreiben können. Sie sind beeindruckend, aber oft fühlen sie sich an wie sehr schlaue, aber letztendlich doch hohle Phrasendrescher. Sie spucken zwar plausible Antworten aus, aber man fragt sich oft: "Verstehen die das überhaupt, was sie da sagen?"

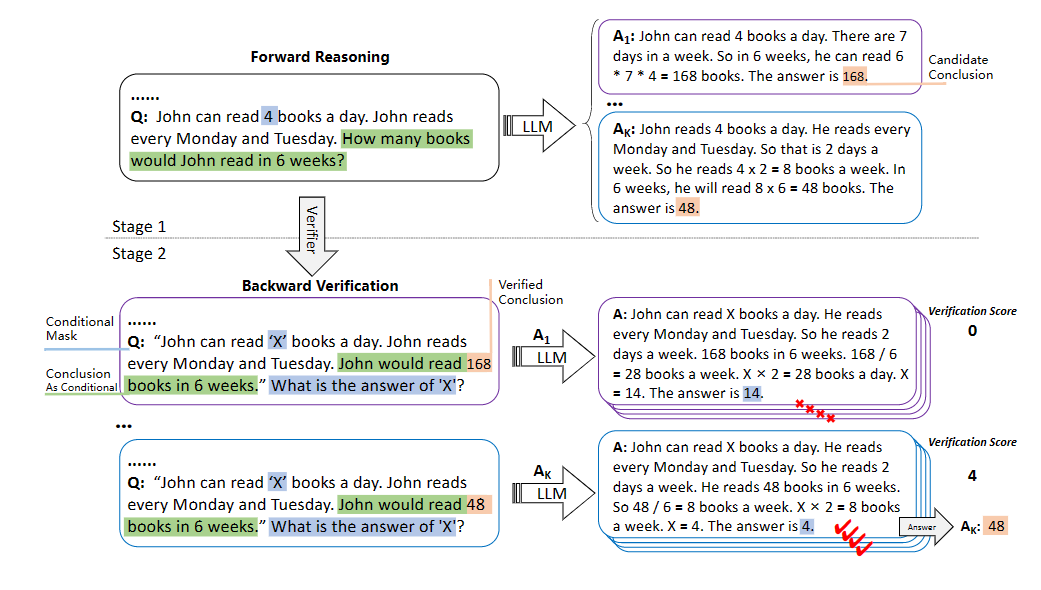

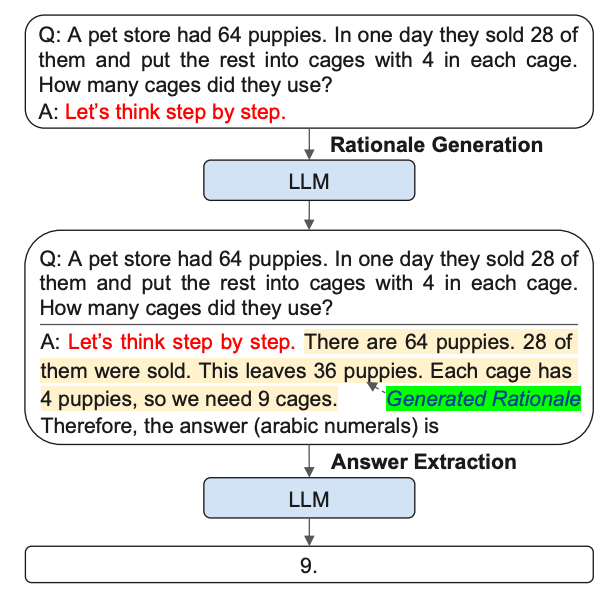

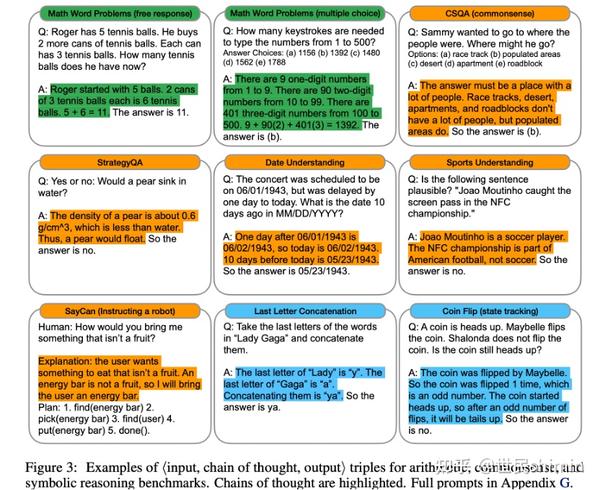

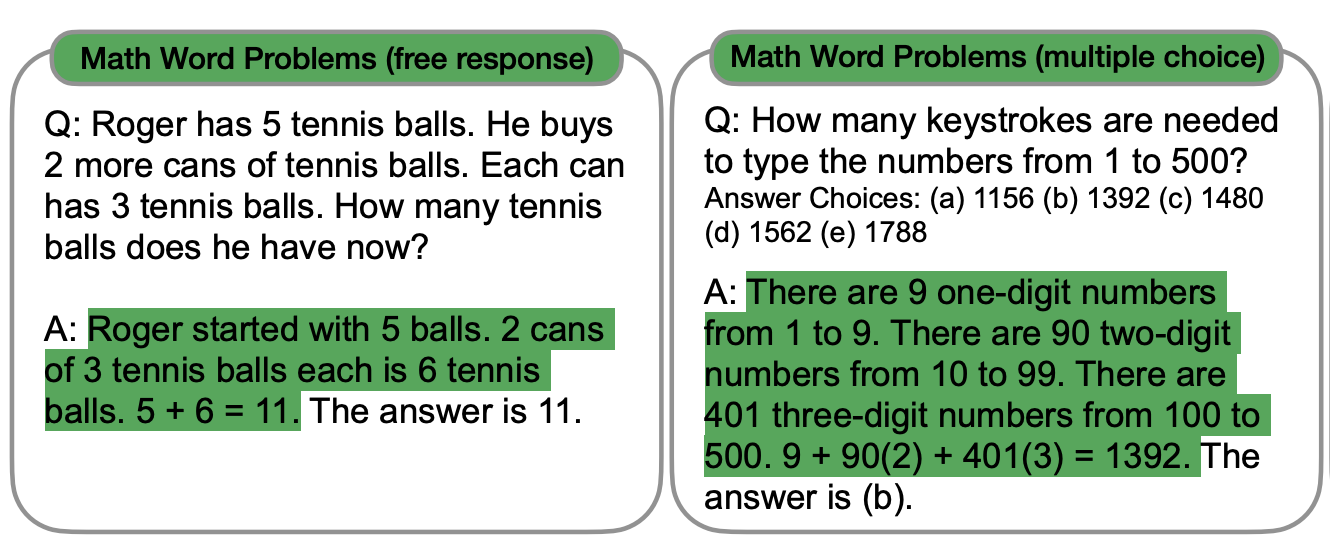

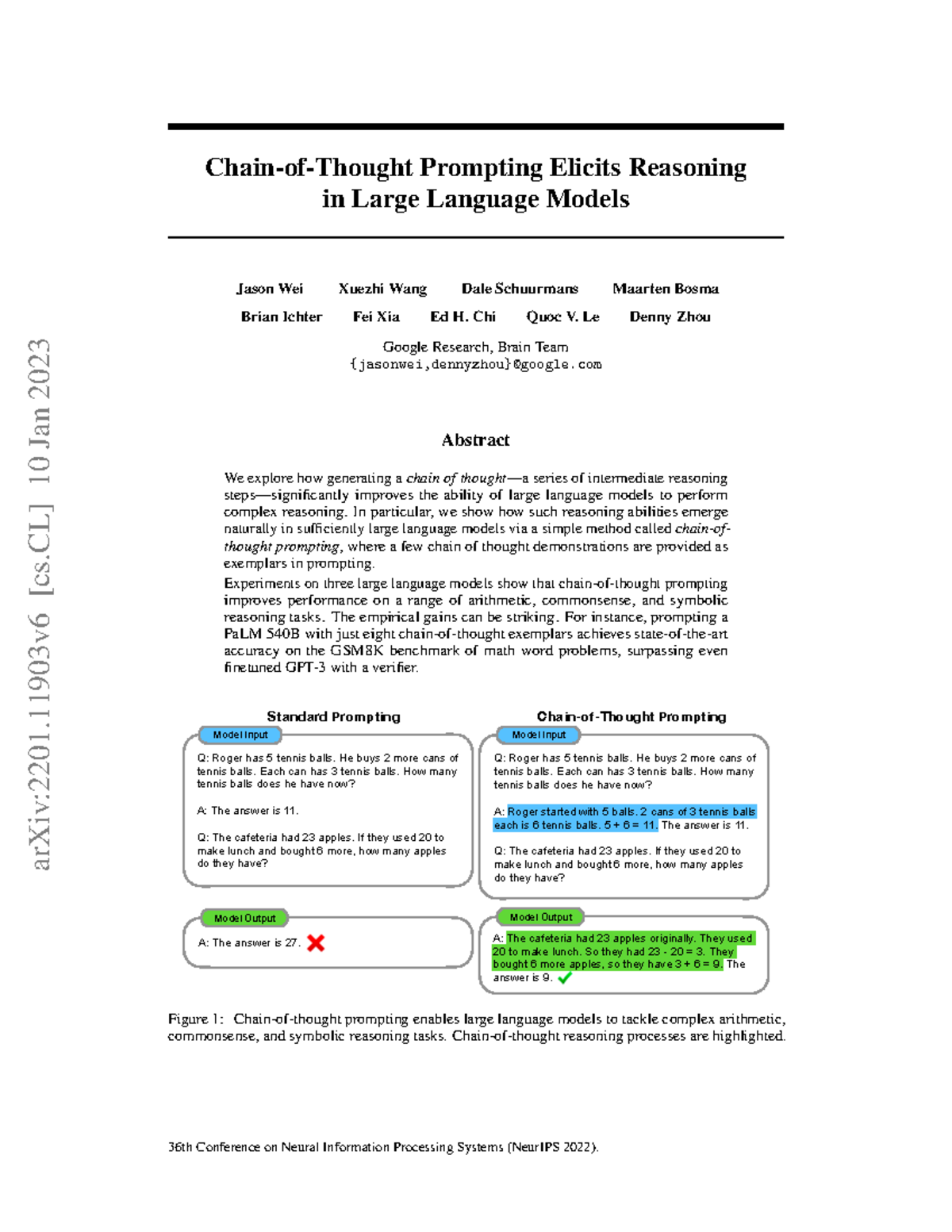

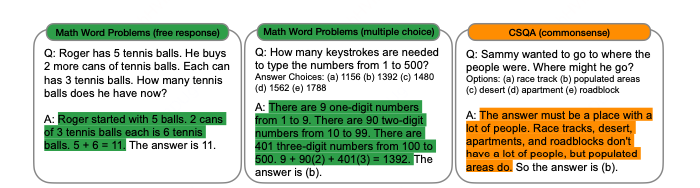

Hier kommt Chain-of-Thought Prompting ins Spiel. Es ist, als würde man den Modellen beibringen, laut zu denken. Anstatt ihnen nur die Frage zu stellen und auf die Antwort zu warten, fordert man sie auf, jeden Schritt ihrer Denkweise zu erklären. Stell dir vor, du fragst:

"Wenn Lisa 3 Äpfel und Paul 2 Bananen hat, und sie tauschen alle Früchte, wie viele Früchte hat Lisa jetzt?"

Früher hätte das Modell vielleicht einfach "2" geantwortet. Jetzt, mit Chain-of-Thought, könnte die Antwort so aussehen:

"Lisa hat 3 Äpfel. Paul hat 2 Bananen. Sie tauschen. Lisa gibt ihre 3 Äpfel weg und bekommt Pauls 2 Bananen. Also hat Lisa jetzt 2 Früchte."

Bäm! Nicht nur die richtige Antwort, sondern auch die logische Schlussfolgerung dahinter. Plötzlich wirkt das Modell nicht mehr wie ein auswendig lernendes Lexikon, sondern wie ein kleiner Einstein, der sich die Sache genau überlegt hat.

Der Aha-Effekt: Von der Raterei zur Rationalität

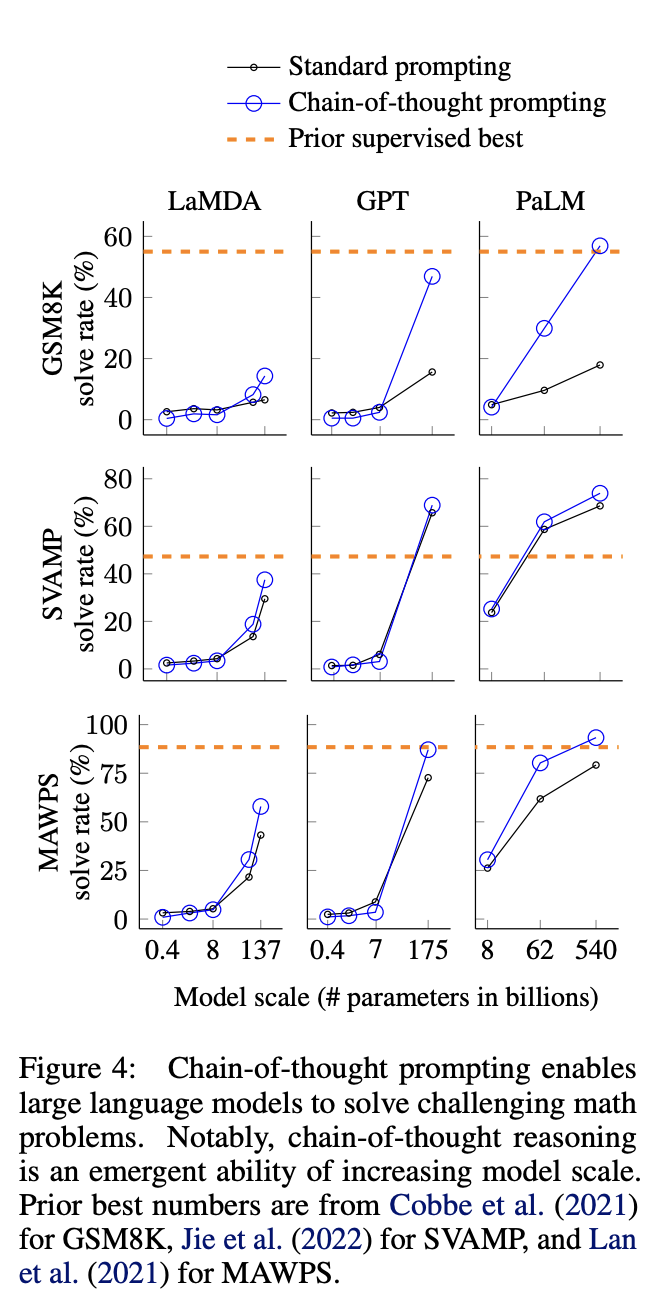

Das wirklich Verblüffende ist, dass diese Modelle nicht speziell auf diese Art des Denkens trainiert wurden. Es ist eher so, als hätte man einen versteckten Schalter gefunden, der ihre verborgenen logischen Fähigkeiten aktiviert. Die Modelle hatten die Fähigkeit schon immer, sie brauchten nur den richtigen Anstoß.

Es ist ein bisschen wie bei einem Zaubertrick. Man weiß, dass es eine Erklärung geben muss, aber die plötzliche Demonstration von Intelligenz ist trotzdem überraschend und faszinierend. Es zeigt, dass diese Modelle viel komplexer sind, als wir bisher angenommen haben.

Und was bedeutet das für uns? Nun, es könnte bedeuten, dass wir bald in der Lage sind, KI-Systeme zu entwickeln, die nicht nur Informationen verarbeiten, sondern auch Probleme lösen und Entscheidungen treffen können, die tatsächlich durchdacht sind. Stell dir vor, ein autonomes Auto, das nicht nur weiß, wann es bremsen muss, sondern auch *warum*.

Humor, Herz und die Zukunft der KI

Abgesehen von den technischen Details gibt es auch eine menschliche Seite an dieser Entwicklung. Die Art und Weise, wie diese Modelle plötzlich "denken", erinnert an Kinder, die gerade anfangen, die Welt zu verstehen und ihre Gedanken laut auszusprechen. Es ist fast schon niedlich, wie sie sich Schritt für Schritt durch ein Problem arbeiten.

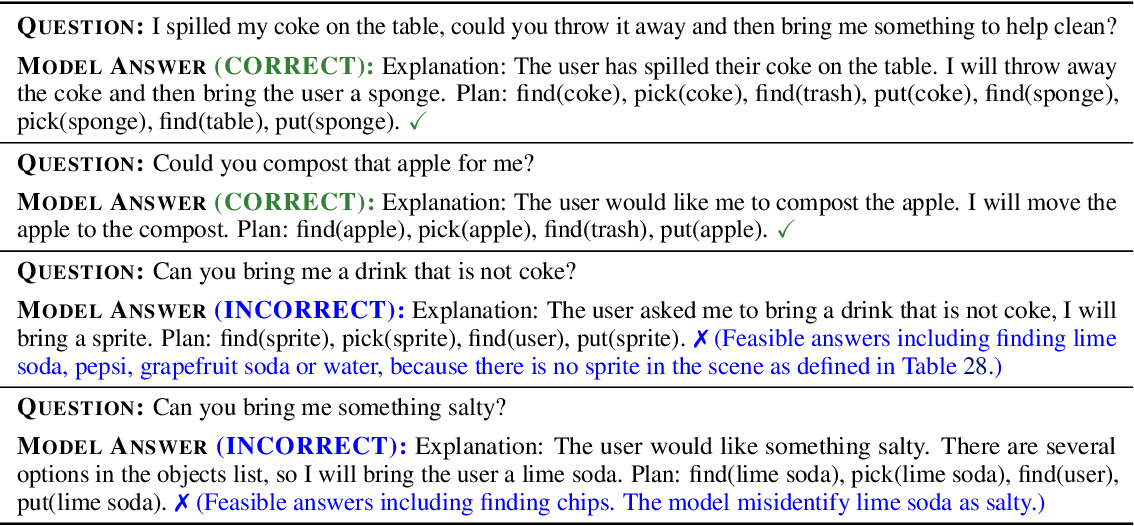

Es gibt auch humorvolle Anekdoten, in denen Modelle aufgrund von Fehlinterpretationen zu abstrusen Schlussfolgerungen kommen. Aber selbst diese Fehler sind lehrreich und zeigen uns, wie wichtig es ist, die Modelle richtig zu trainieren und ihnen die richtigen Informationen zu geben. Garbage in, garbage out, wie man so schön sagt – selbst bei Superhirnen aus Silizium.

Die Zukunft der KI ist ungewiss, aber Chain-of-Thought Prompting hat uns einen aufregenden Einblick in das Potenzial dieser Technologie gegeben. Es zeigt uns, dass wir noch lange nicht am Ende der Fahnenstange angelangt sind und dass es noch viele verborgene Fähigkeiten in diesen Modellen zu entdecken gibt.

Also, das nächste Mal, wenn du mit einem großen Sprachmodell chattest, versuche es doch mal mit Chain-of-Thought. Frag es nicht nur nach der Antwort, sondern auch nach dem *Warum*. Vielleicht wirst du überrascht sein, was du entdeckst.

Und wer weiß, vielleicht lernen wir am Ende nicht nur die KI das Denken, sondern auch uns selbst ein bisschen besser zu verstehen.