Time Complexity In Algorithms

Stell dir vor, du bist auf einer Schnitzeljagd. Dein Ziel: Eine einzige rote Gummibärchen versteckt in einem riesigen Süßwarenladen. Du hast zwei Strategien zur Auswahl.

Strategie A: Du gehst systematisch vor. Du beginnst am ersten Regal, schaust jedes einzelne Bonbonglas an, jede einzelne Tüte, jede einzelne Praline. Du arbeitest dich Regal für Regal vor, bis du endlich, nach Stunden, das rote Gummibärchen entdeckst. Glückwunsch! Du hast gewonnen... aber war das wirklich die effizienteste Methode?

Strategie B: Du fragst direkt den Ladenbesitzer, der seit Jahrzehnten hier arbeitet. "Wo verstecken Sie denn immer die roten Gummibärchen?", fragst du. Der Ladenbesitzer grinst und zeigt auf ein bestimmtes Bonbonglas direkt hinter der Kasse. Du hast das rote Gummibärchen in Sekundenschnelle gefunden!

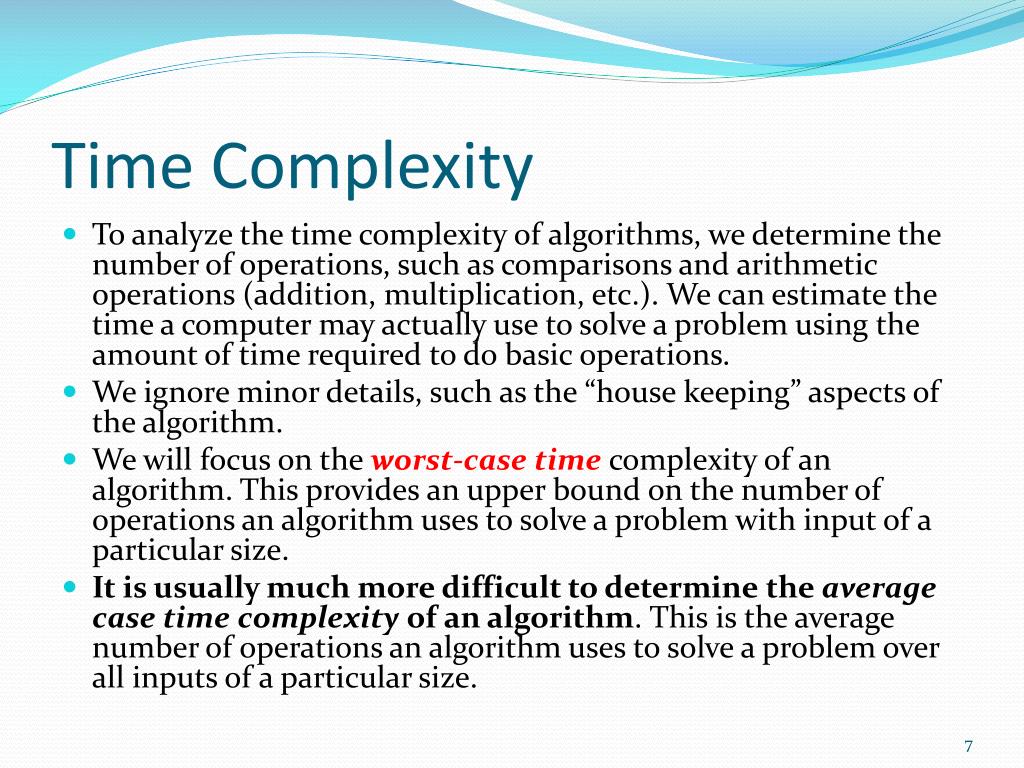

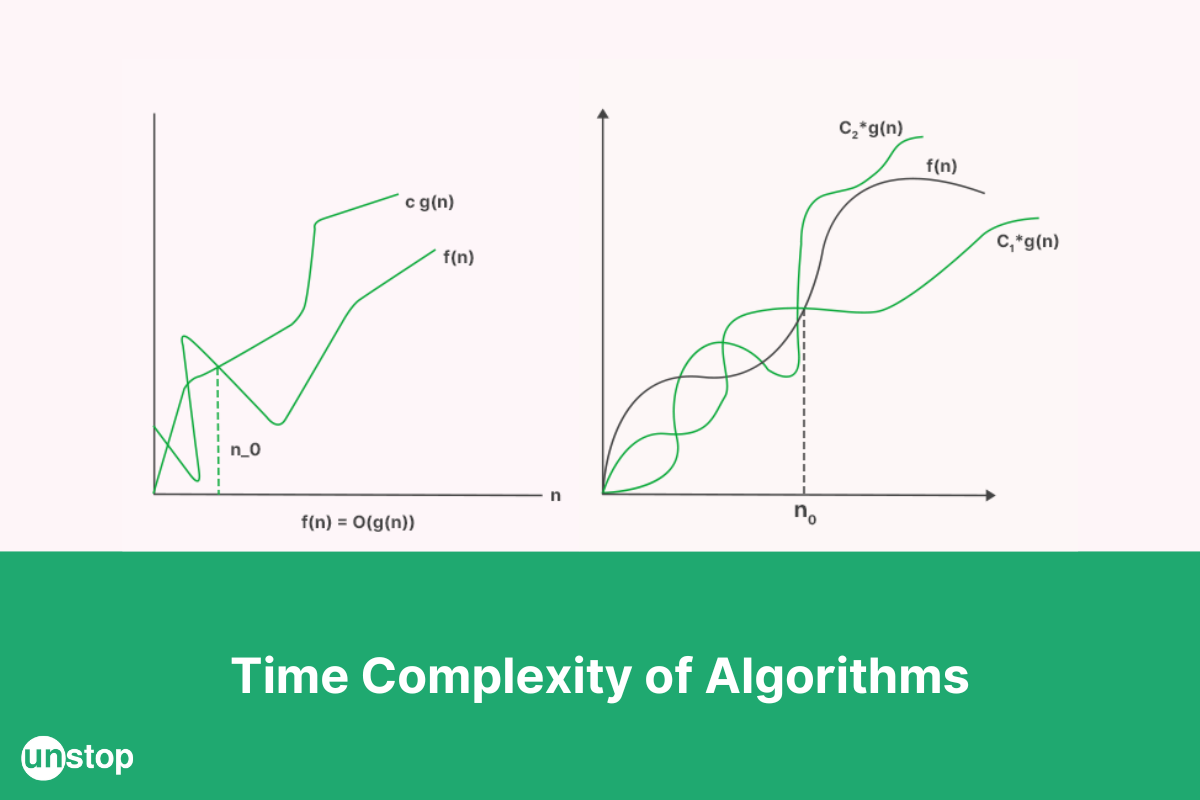

Was hat das mit Zeitkomplexität in Algorithmen zu tun? Nun, genau das ist der Punkt! Zeitkomplexität ist im Grunde genommen, wie lange ein Algorithmus braucht, um ein Problem zu lösen, abhängig von der Größe des Problems. Der Süßwarenladen ist die "Größe des Problems", das rote Gummibärchen zu finden ist die "Aufgabe" und die beiden Strategien sind unterschiedliche Algorithmen.

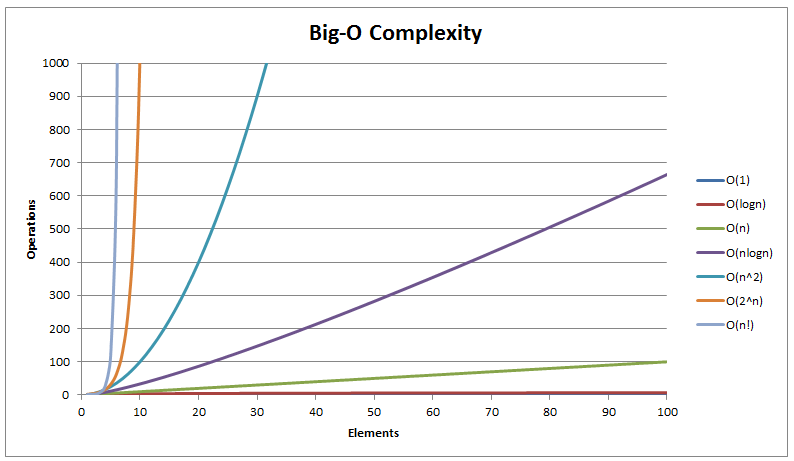

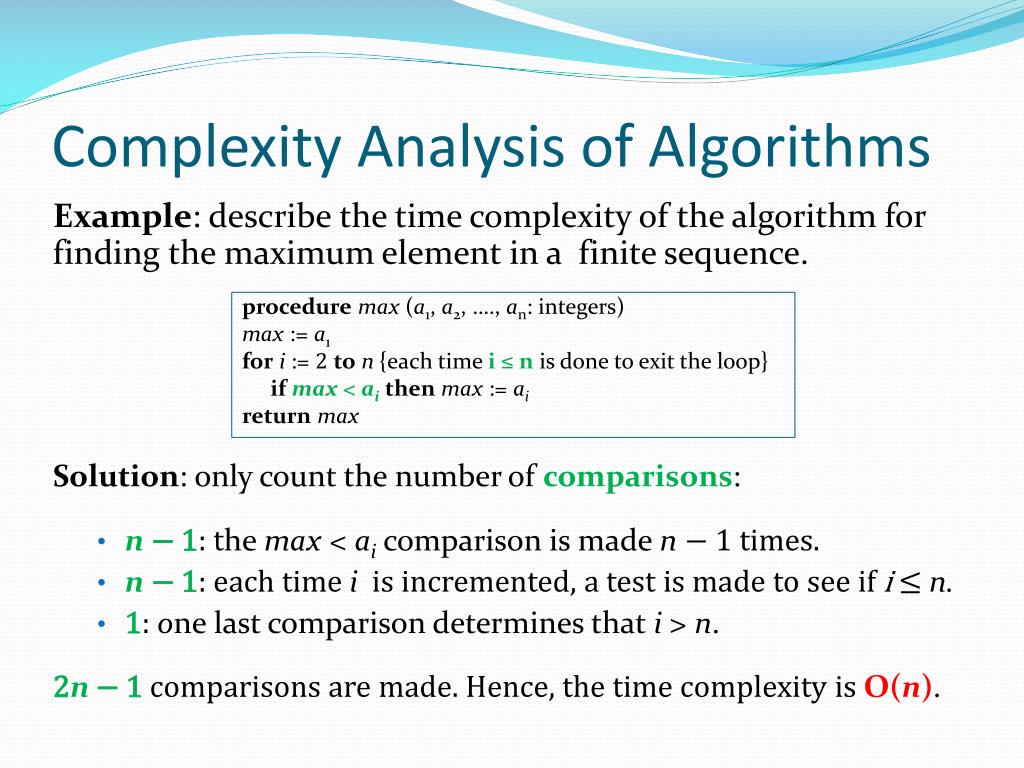

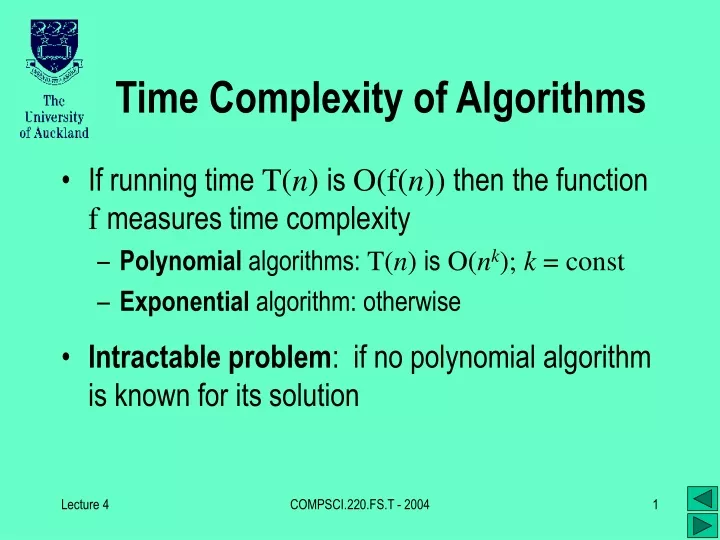

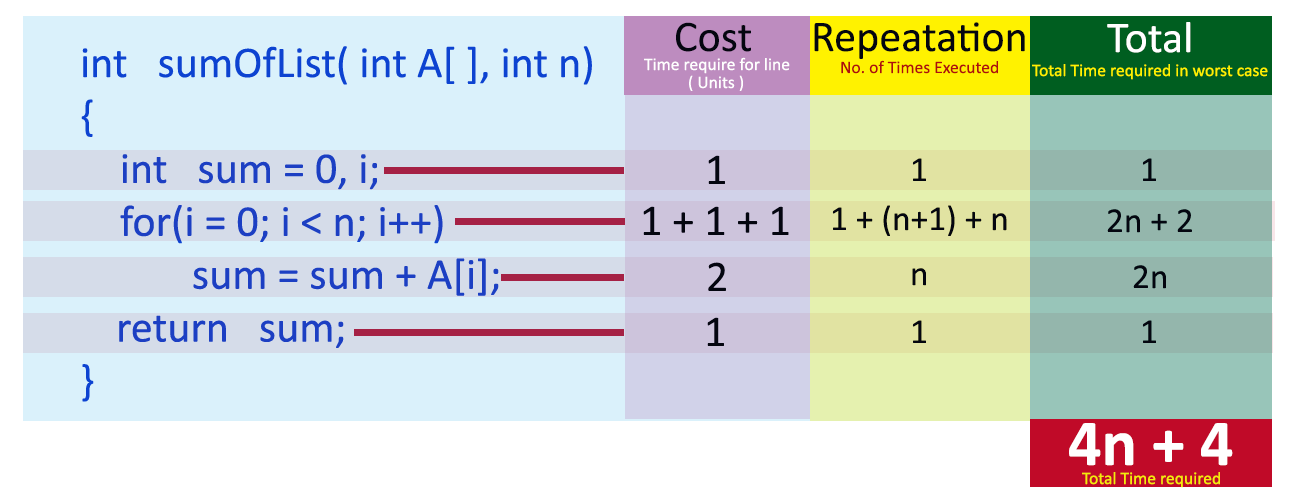

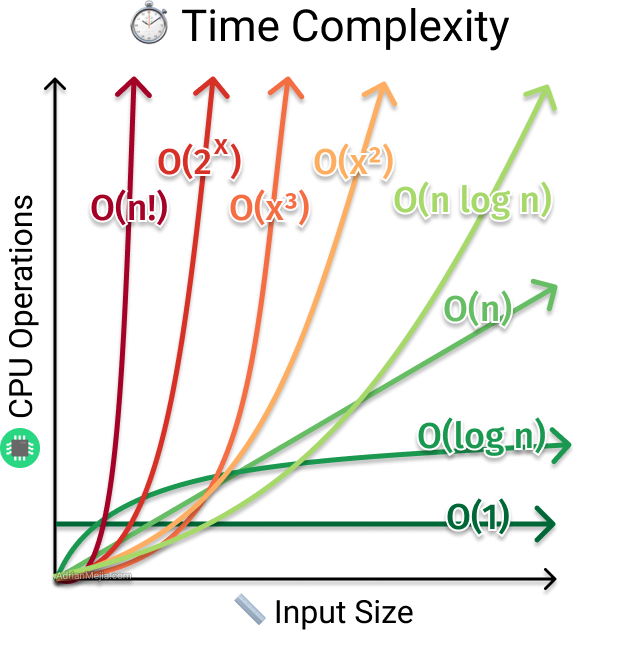

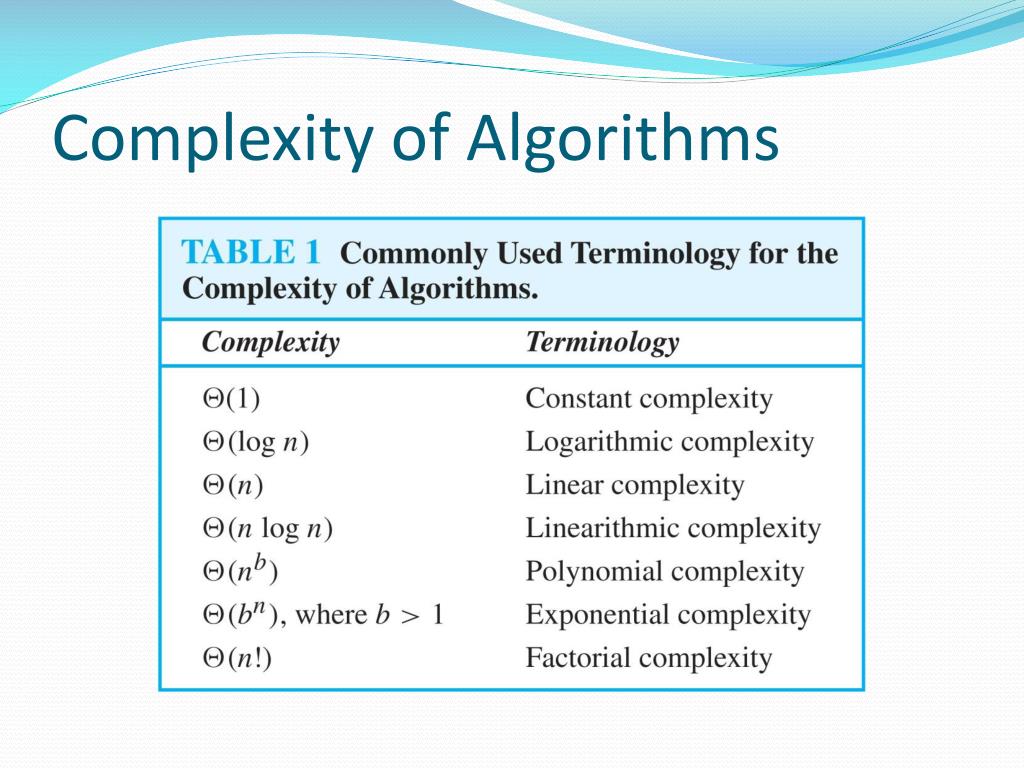

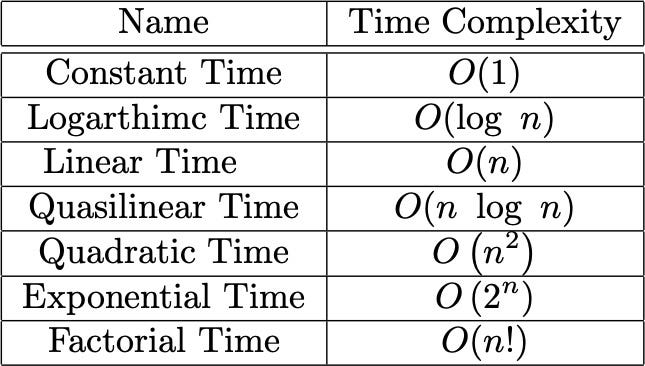

Strategie A, das systematische Absuchen, ist wie ein Algorithmus mit einer schlechten Zeitkomplexität. Sagen wir, der Süßwarenladen hat 1000 Produkte. Im schlimmsten Fall (das Gummibärchen ist ganz am Ende versteckt) musst du alle 1000 Produkte überprüfen. Wenn der Laden doppelt so groß wäre, müsstest du 2000 Produkte überprüfen. Die Zeit, die du brauchst, wächst also direkt proportional zur Größe des Ladens. Das nennt man lineare Zeitkomplexität, oft mit O(n) abgekürzt, wobei 'n' für die Größe des Problems steht.

Strategie B, das Fragen des Ladenbesitzers, ist wie ein Algorithmus mit einer fantastischen Zeitkomplexität. Es ist egal, ob der Laden 1000 Produkte oder 1 Million Produkte hat. Du fragst und bekommst sofort die Antwort. Die Zeit, die du brauchst, bleibt gleich! Das nennt man konstante Zeitkomplexität, abgekürzt mit O(1). Ein Traum!

Warum ist das wichtig?

Weil in der Welt der Computerprobleme die "Süßwarenläden" gigantisch groß sein können. Stell dir vor, du suchst in einer Datenbank mit Millionen von Einträgen nach einem bestimmten Namen. Oder du sortierst eine Liste mit Milliarden von Zahlen. Ein Algorithmus mit linearer Zeitkomplexität könnte Stunden, Tage oder sogar Jahre brauchen, während ein Algorithmus mit konstanter oder logarithmischer Zeitkomplexität das Problem in Sekunden lösen könnte.

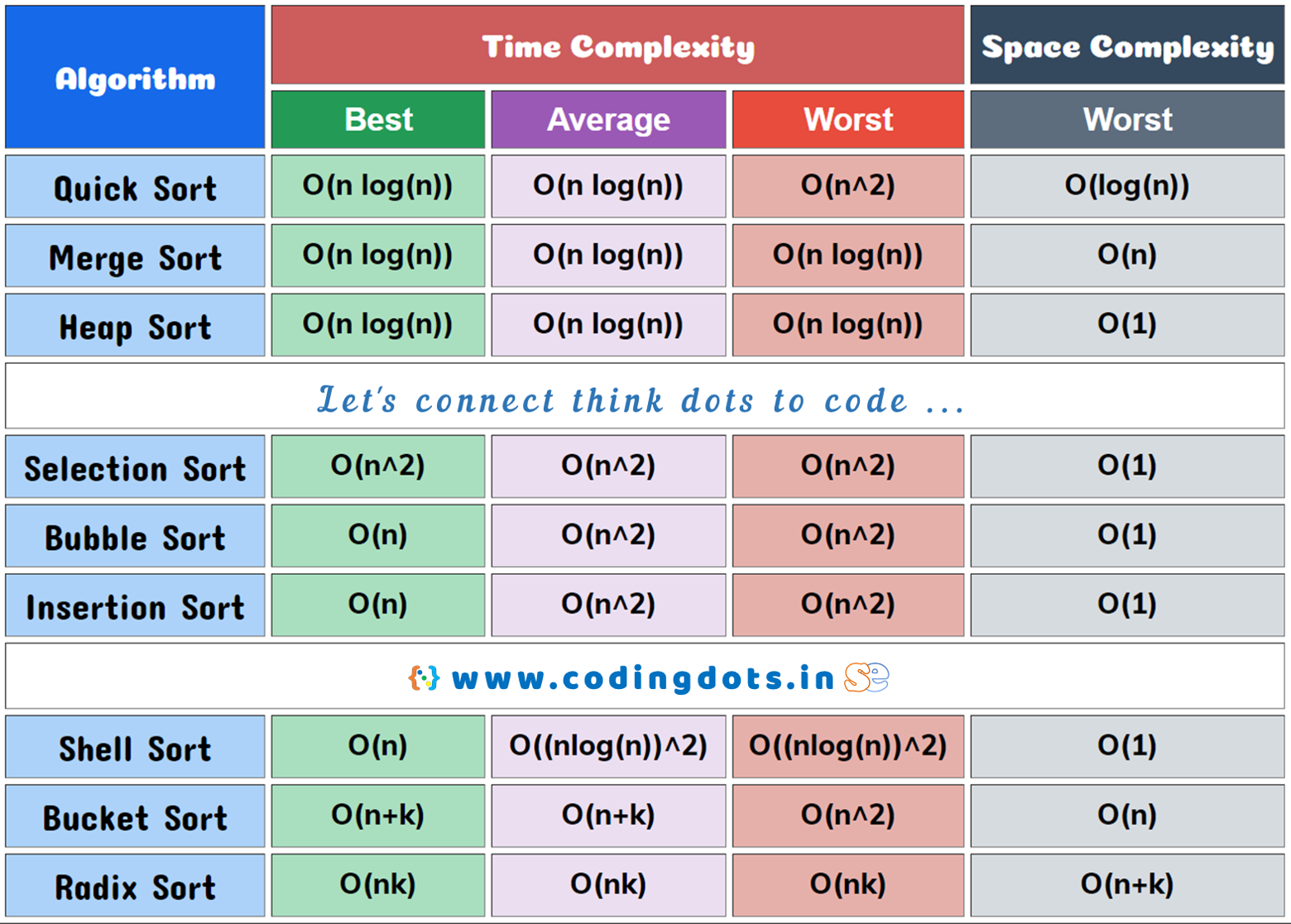

Und hier wird es wirklich interessant: Oftmals gibt es nicht nur eine einzige Möglichkeit, ein Problem zu lösen. Es gibt verschiedene Algorithmen mit unterschiedlichen Zeitkomplexitäten. Die Wahl des richtigen Algorithmus kann den Unterschied zwischen einem blitzschnellen Erfolg und einer frustrierenden Ewigkeit ausmachen.

Die überraschende Seite der Zeitkomplexität

Manchmal ist der "einfachste" Algorithmus nicht der schnellste. Der Algorithmus, der auf dem Papier am offensichtlichsten erscheint, hat vielleicht eine schreckliche Zeitkomplexität. Das ist so, als würdest du denken, der kürzeste Weg nach Hause ist immer die gerade Linie, aber in Wirklichkeit führt eine Abkürzung durch einen Park schneller zum Ziel, obwohl sie auf der Karte länger aussieht.

Es gibt Algorithmen mit quadratischer Zeitkomplexität (O(n²)), bei denen die Zeit, die sie brauchen, mit dem Quadrat der Größe des Problems wächst. Das ist wie eine Spirale der Ineffizienz! Stell dir vor, du musst jedes Produkt im Süßwarenladen mit jedem anderen Produkt vergleichen... ohje!

Die herzerwärmende Seite der Optimierung

Es ist fast wie Magie, wenn du einen Algorithmus von einer schlechten Zeitkomplexität zu einer besseren optimieren kannst. Du hast das Gefühl, etwas geschaffen zu haben, das effizienter, schneller und einfach besser ist. Es ist, als würdest du einem lahmen Entlein das Fliegen beibringen.

Und manchmal ist es Teamwork! Entwickler arbeiten oft zusammen, um Algorithmen zu verbessern und die Zeitkomplexität zu reduzieren. Es ist ein gemeinsames Streben nach Effizienz, eine Art digitaler Olympischer Spiele, bei denen es darum geht, die schnellste Lösung zu finden.

Es ist wichtig zu verstehen, dass Zeitkomplexität nicht alles ist. Manchmal ist ein einfacher, gut verständlicher Algorithmus mit etwas schlechterer Zeitkomplexität besser als ein komplexer, schwer verständlicher Algorithmus mit einer geringfügig besseren Zeitkomplexität. Lesbarkeit und Wartbarkeit des Codes sind ebenfalls entscheidend.

Also, das nächste Mal, wenn du ein Computerprogramm benutzt, denk an die Zeitkomplexität und die unsichtbaren Algorithmen, die im Hintergrund arbeiten. Denk an den Süßwarenladen und das rote Gummibärchen. Und vielleicht wirst du die Magie der effizienten Problemlösung ein bisschen mehr schätzen.

Denn in der Welt der Algorithmen ist Zeit wirklich Geld – und manchmal auch ein rotes Gummibärchen wert.

![Time Complexity In Algorithms Basics of Time Complexity Analysis [+ notations and Complexity class]](https://iq.opengenus.org/content/images/2021/08/time-complexity.jpg)