Wann Wurde Das Deutsche Reich Gegründet

Hallo! Du planst einen Trip nach Deutschland oder bist vielleicht sogar schon hier? Super! Wenn du dich für die Geschichte des Landes interessierst, stolperst du früher oder später über das Deutsche Reich. Aber wann genau wurde dieses Reich eigentlich gegründet? Und was steckt dahinter? Keine Sorge, wir machen das Thema für dich ganz einfach und spannend!

Die Gründung des Deutschen Reiches: Ein historischer Moment

Die Antwort auf die Frage "Wann wurde das Deutsche Reich gegründet?" ist relativ eindeutig: Am 18. Januar 1871. Aber um das ganze Ausmaß dieses Ereignisses zu verstehen, müssen wir ein bisschen weiter ausholen.

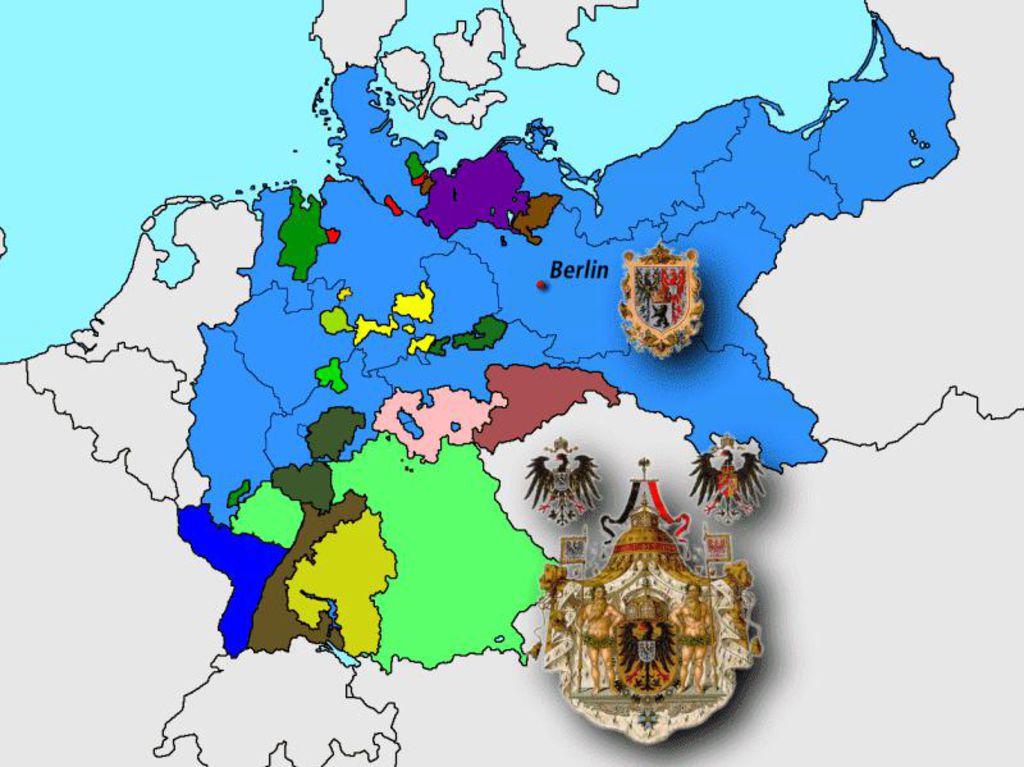

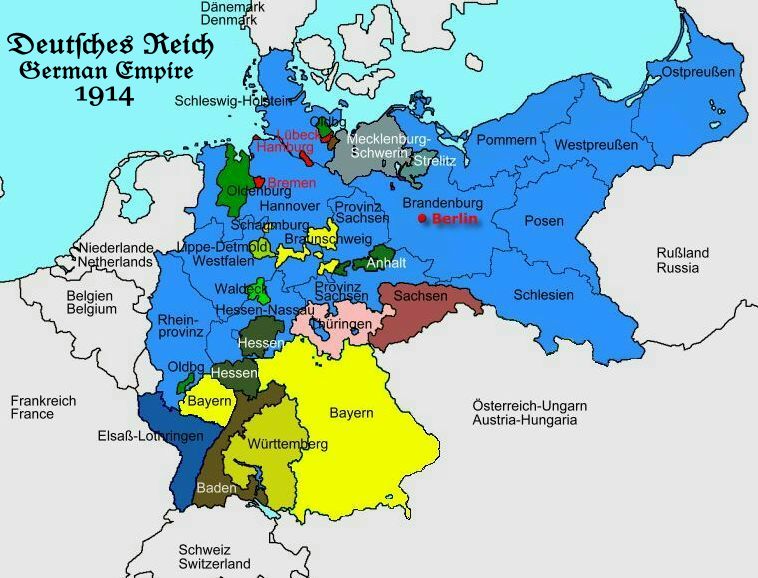

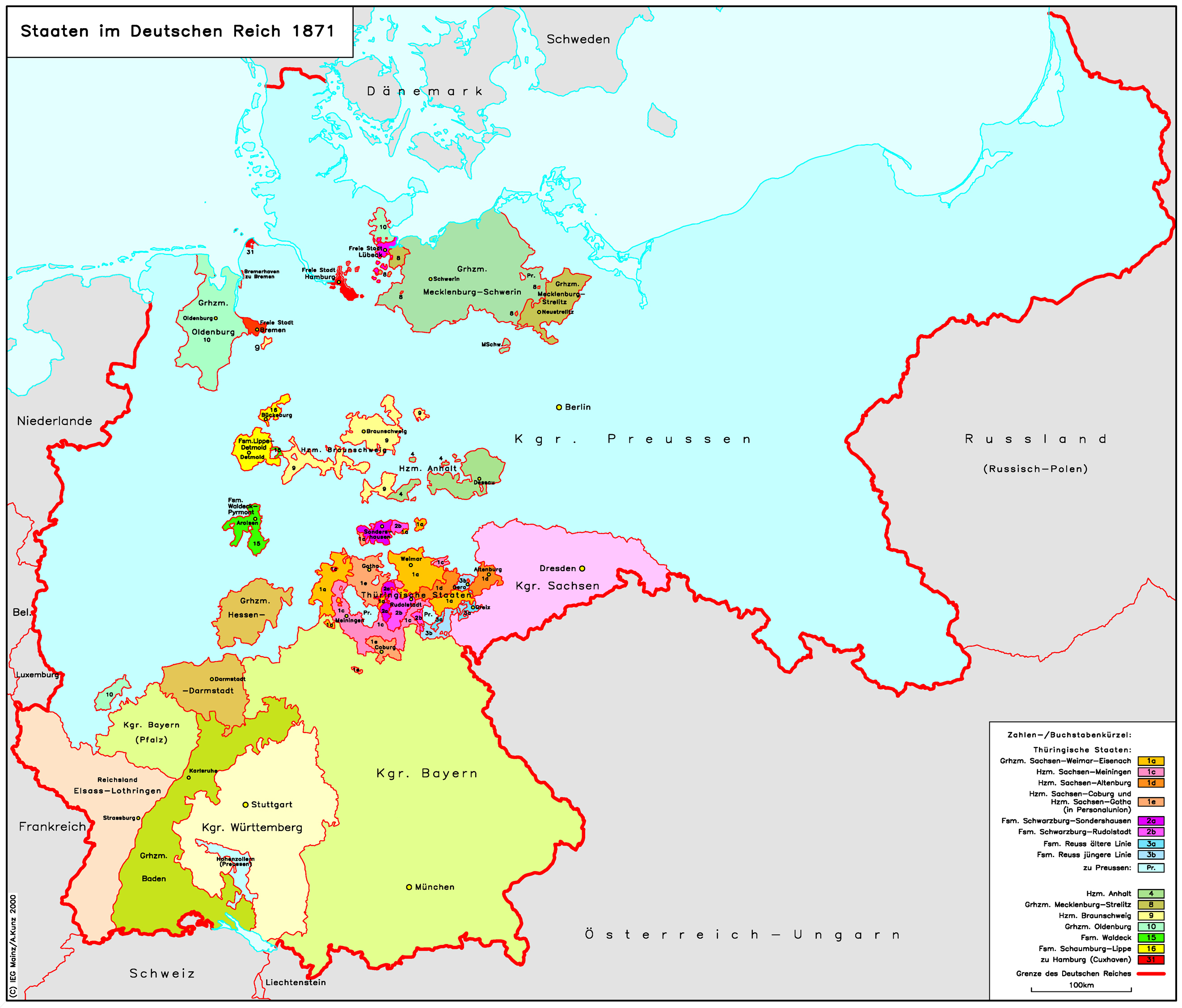

Die Zeit vor der Reichsgründung: Ein Flickenteppich

Vor 1871 war Deutschland kein einheitlicher Staat, sondern bestand aus einer Vielzahl von Königreichen, Herzogtümern, Fürstentümern und freien Städten. Stell dir das wie einen riesigen Flickenteppich vor, in dem jedes einzelne "Feld" seine eigenen Regeln und Gesetze hatte. Der sogenannte Deutsche Bund, der 1815 nach dem Wiener Kongress gegründet wurde, sollte zwar eine gewisse Ordnung schaffen, war aber eher ein lockerer Zusammenschluss souveräner Staaten. Das Problem war: Es fehlte eine starke, zentrale Regierung, die das Ganze zusammenhält.

Dieser Zustand war vor allem für den Handel und die Wirtschaft hinderlich. Zölle und unterschiedliche Währungen machten es schwer, Waren zwischen den einzelnen Territorien auszutauschen. Viele Menschen träumten von einem geeinten Deutschland, in dem es keine solchen Hindernisse mehr geben würde. Und hier kommt Otto von Bismarck ins Spiel.

Otto von Bismarck: Der "Eiserne Kanzler"

Otto von Bismarck war der preußische Ministerpräsident und ein brillanter Stratege. Er hatte das Ziel, Deutschland unter preußischer Führung zu einigen. Dabei war er nicht zimperlich und setzte auf eine Politik der "Eisen und Blut", wie er es selbst nannte. Das bedeutete, dass er bereit war, Kriege zu führen, um seine Ziele zu erreichen.

Bismarck führte Preußen in drei Kriege, die letztendlich zur Reichsgründung führten:

- Der Deutsch-Dänische Krieg (1864): Preußen und Österreich kämpften gemeinsam gegen Dänemark um die Herzogtümer Schleswig und Holstein.

- Der Deutsch-Österreichische Krieg (1866): Preußen besiegte Österreich und löste den Deutschen Bund auf. Es gründete den Norddeutschen Bund unter preußischer Führung.

- Der Deutsch-Französische Krieg (1870/71): Bismarck provozierte Frankreich zu einer Kriegserklärung, den Preußen und seine Verbündeten gewannen.

Der Deutsch-Französische Krieg war der entscheidende Schritt zur Reichsgründung. Die süddeutschen Staaten, die sich bisher noch gesträubt hatten, traten nun dem Norddeutschen Bund bei. Die gemeinsame Kriegserfahrung schweißte die Deutschen zusammen und stärkte das Nationalgefühl.

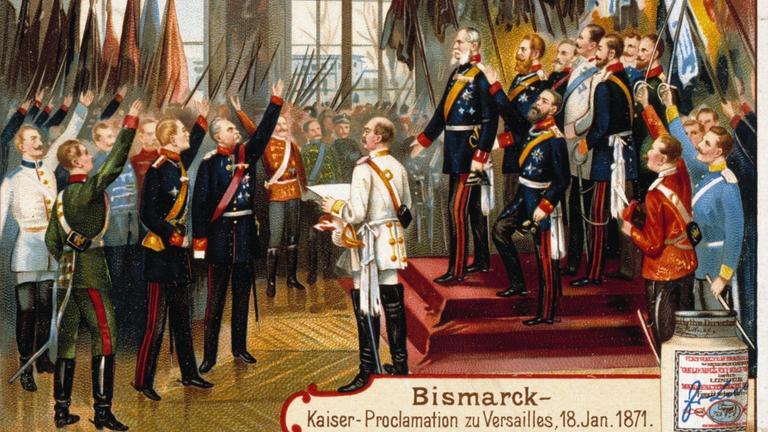

Der 18. Januar 1871: Die Kaiserproklamation in Versailles

Der symbolträchtige Akt der Reichsgründung fand nicht in Deutschland statt, sondern im Spiegelsaal von Schloss Versailles in Frankreich. Das lag daran, dass die deutschen Truppen Paris belagerten und Versailles als Hauptquartier nutzten. Dort wurde der preußische König Wilhelm I. zum Deutschen Kaiser proklamiert. Damit war das Deutsche Reich offiziell gegründet.

Es war ein beeindruckender Moment, der das Ende einer langen Epoche der Zersplitterung markierte und den Beginn eines neuen Kapitels in der deutschen Geschichte einleitete. Die Proklamation wurde von zahlreichen deutschen Fürsten, Militärs und Politikern bezeugt. Es war eine Machtdemonstration Preußens und ein Zeichen für die neu gewonnene Einheit Deutschlands.

"Wir Wilhelm, von Gottes Gnaden Deutscher Kaiser, König von Preußen..." - Beginn der Kaiserproklamation

Was bedeutete die Reichsgründung für Deutschland?

Die Reichsgründung hatte weitreichende Folgen für Deutschland. Hier sind einige der wichtigsten Auswirkungen:

- Einheitlicher Staat: Deutschland war nun ein einheitlicher Staat mit einer zentralen Regierung, einer Verfassung und einer gemeinsamen Währung (die Mark wurde 1873 eingeführt).

- Wirtschaftlicher Aufschwung: Die Beseitigung der Zölle und die Vereinheitlichung des Wirtschaftsraumes führten zu einem enormen wirtschaftlichen Aufschwung. Deutschland entwickelte sich in kurzer Zeit zu einer der führenden Industrienationen Europas.

- Politisches Gewicht: Das Deutsche Reich gewann an politischem Gewicht in Europa und wurde zu einem wichtigen Akteur in der internationalen Politik.

- Nationalgefühl: Die Reichsgründung stärkte das Nationalgefühl der Deutschen und führte zu einer neuen Identität.

Allerdings hatte die Reichsgründung auch Schattenseiten. Die autoritäre Politik Bismarcks und die Militarisierung der Gesellschaft führten zu Spannungen und Konflikten, die letztendlich im Ersten Weltkrieg mündeten.

Die Weimarer Republik und das "Dritte Reich"

Das Deutsche Reich von 1871 bestand bis zum Ende des Ersten Weltkriegs im Jahr 1918. Nach dem Krieg wurde die Monarchie abgeschafft und die Weimarer Republik gegründet. Diese Republik war jedoch von Anfang an von großen Problemen geplagt und scheiterte schließlich an den wirtschaftlichen und politischen Krisen der 1920er und 1930er Jahre.

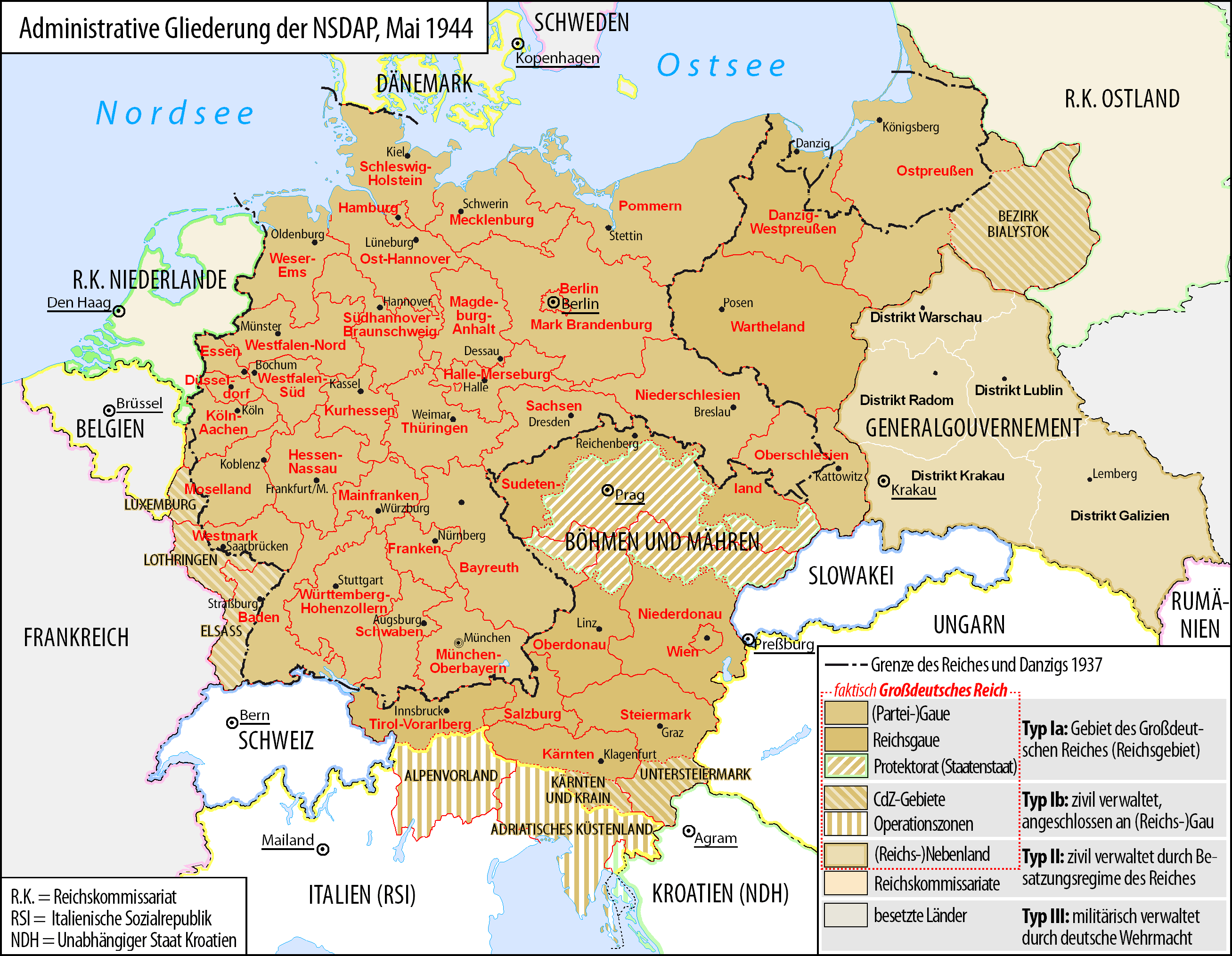

1933 übernahm Adolf Hitler die Macht und errichtete das sogenannte "Dritte Reich", eine nationalsozialistische Diktatur, die Deutschland in den Zweiten Weltkrieg führte und unvorstellbare Verbrechen beging. Nach dem Ende des Zweiten Weltkriegs wurde Deutschland in vier Besatzungszonen aufgeteilt und verlor seine östlichen Gebiete.

Die Teilung Deutschlands und die Wiedervereinigung

Nach dem Zweiten Weltkrieg wurde Deutschland in die Bundesrepublik Deutschland (Westdeutschland) und die Deutsche Demokratische Republik (Ostdeutschland) geteilt. Erst mit dem Fall der Berliner Mauer im Jahr 1989 und der Wiedervereinigung im Jahr 1990 wurde Deutschland wieder zu einem geeinten Staat.

Warum ist das wichtig für dich als Tourist oder Expat?

Das Verständnis der deutschen Geschichte, einschließlich der Reichsgründung, hilft dir, die Kultur, die Politik und die Mentalität der Deutschen besser zu verstehen. Wenn du zum Beispiel durch Berlin spazierst und das Brandenburger Tor siehst, oder wenn du dich in einem Museum über die Geschichte des Landes informierst, wirst du die Bedeutung dieser Orte und Ereignisse besser erfassen können, wenn du ein grundlegendes Wissen über die deutsche Geschichte hast.

Außerdem kann es dir helfen, Fettnäpfchen zu vermeiden. Einige Themen sind in Deutschland immer noch sehr sensibel, wie zum Beispiel die Zeit des Nationalsozialismus. Ein respektvoller Umgang mit der Geschichte ist daher sehr wichtig.

Tipps für deine Erkundungstour:

- Besuche historische Orte: In Berlin gibt es zahlreiche Museen und Gedenkstätten, die sich mit der deutschen Geschichte auseinandersetzen, wie zum Beispiel das Deutsche Historische Museum, das Dokumentationszentrum NS-Zeit und die Gedenkstätte Berliner Mauer.

- Lies Bücher und Artikel: Es gibt unzählige Bücher und Artikel über die deutsche Geschichte. Informiere dich vor deiner Reise oder während deines Aufenthalts über die wichtigsten Ereignisse und Persönlichkeiten.

- Sprich mit Einheimischen: Frage deine deutschen Freunde, Kollegen oder Gastgeber nach ihrer Sicht auf die Geschichte. Sie können dir oft interessante Einblicke und Perspektiven geben.

Die deutsche Geschichte ist komplex und facettenreich. Aber sie ist auch unglaublich spannend und lehrreich. Indem du dich mit ihr auseinandersetzt, wirst du Deutschland und seine Menschen besser verstehen lernen. Wir hoffen, dieser kleine Ausflug in die Geschichte der Reichsgründung hat dir gefallen! Viel Spaß bei deiner Erkundungstour durch Deutschland!

![Wann Wurde Das Deutsche Reich Gegründet Reichsgründung • Gründung Deutsches Reich 1871 · [mit Video]](https://d1g9li960vagp7.cloudfront.net/wp-content/uploads/2021/10/deutsches-Reich-1024x576.jpg)

![Wann Wurde Das Deutsche Reich Gegründet Deutsches Kaiserreich - [GEO]](https://image.geo.de/30376102/t/QG/v2/w960/r1.5/-/das-deutsche-kaiserreich-d-45248707-jpg--90092-.jpg)