Seit Wann Gibt Es Fußball In Deutschland

Hallo liebe Reisefreunde und Fußballbegeisterte! Stellt euch vor, ihr sitzt in einem urigen Café in Deutschland, der Duft von frisch gebrühtem Kaffee steigt euch in die Nase, und im Hintergrund diskutieren die Einheimischen leidenschaftlich über... Fußball! Eine Frage, die mir auf meinen Reisen oft gestellt wird, ist: "Seit wann gibt es eigentlich Fußball in Deutschland?" Lasst mich euch mitnehmen auf eine kleine Zeitreise durch die faszinierende Geschichte des deutschen Fußballs. Es ist eine Geschichte voller Pioniere, Leidenschaft und unvergesslicher Momente.

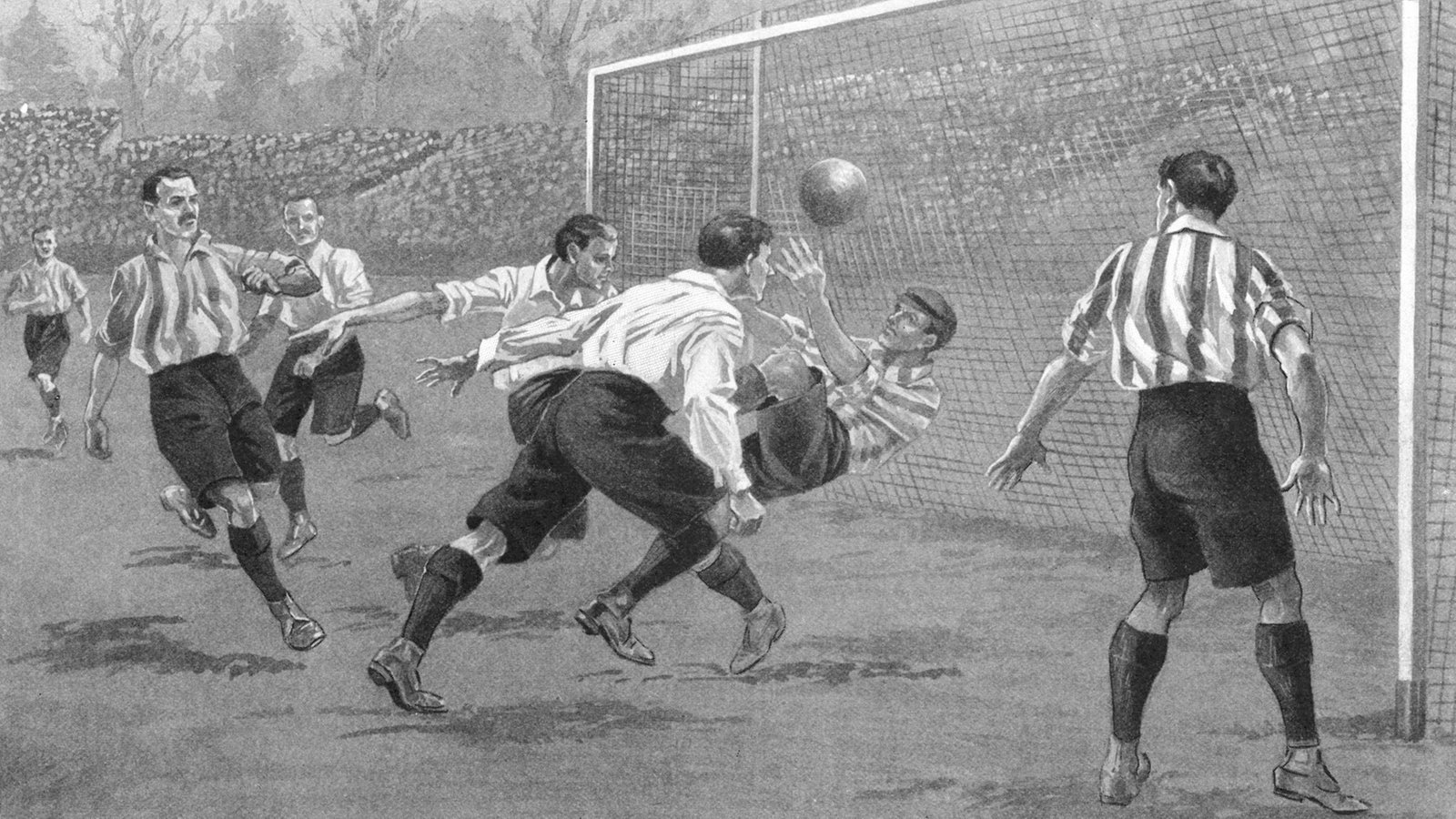

Die Wurzeln des deutschen Fußballs reichen überraschend weit zurück, genauer gesagt, ins späte 19. Jahrhundert. Während ich in England war, dem Mutterland des Fußballs, wurde mir klar, dass die Begeisterung für diesen Sport schnell über die Grenzen hinaus schwappte. Und Deutschland, mit seiner aufstrebenden Industrialisierung und dem wachsenden Interesse an neuen Ideen, war ein idealer Nährboden.

Die ersten Kicks und Gründerjahre

Offiziell begann alles mit der Gründung erster Fußballvereine. Die Pionierarbeit leisteten dabei oft Schüler und Studenten, die während ihrer Auslandsaufenthalte in England mit dem Fußball in Berührung gekommen waren. Stellt euch vor: Junge Leute, begeistert von einem neuen Spiel, die voller Tatendrang versuchten, diese Begeisterung auch in ihrer Heimat zu entfachen. Einer der ersten dokumentierten Vereine war der Dresdner English Football Club, gegründet im Jahr 1874. Ihr lest richtig! Schon damals gab es organisiertes Fußballspielen in Deutschland. Allerdings war dieser Verein, wie der Name schon sagt, stark von englischen Einflüssen geprägt.

Es folgten weitere Gründungen, darunter der Berliner FC Germania 1888 und der Hannover 1878. Diese frühen Vereine waren oft sehr elitär und konzentrierten sich auf bestimmte soziale Schichten. Das Spiel war noch nicht so populär wie heute, aber die Saat war gesät. Ich erinnere mich an einen Besuch im Deutschen Fußballmuseum in Dortmund, wo ich alte Fotos und Dokumente aus dieser Zeit sah. Es war faszinierend zu sehen, wie rudimentär die Ausrüstung war und wie anders die Spielregeln waren.

Im Jahr 1900, ein entscheidendes Datum in der deutschen Fußballgeschichte, wurde der Deutsche Fußball-Bund (DFB) gegründet. Stellt euch vor, eine Gruppe von Vertretern verschiedener Vereine kommt zusammen, um eine gemeinsame Organisation zu schaffen, die den Fußball in Deutschland strukturieren und fördern soll. Das war ein wichtiger Schritt, um den Sport aus den Kinderschuhen zu holen und ihm eine nationale Identität zu geben. Die Gründung des DFB legte den Grundstein für die Entwicklung des professionellen Fußballs, wie wir ihn heute kennen.

Die frühen Meisterschaften und Herausforderungen

Die ersten deutschen Fußballmeisterschaften wurden in den Folgejahren ausgetragen. Die Spiele waren oft lokale Ereignisse mit begrenzter Zuschauerzahl, aber sie zeigten, dass der Fußball in Deutschland langsam, aber stetig an Popularität gewann. Die ersten Titel wurden von Vereinen aus verschiedenen Regionen gewonnen, was die Vielfalt des deutschen Fußballs in seinen Anfängen widerspiegelte. Es gab noch keine flächendeckende Liga, sondern regionale Meisterschaften, deren Sieger dann in einer Endrunde den deutschen Meister ermittelten.

Allerdings gab es auch Herausforderungen. Der Fußball war in den ersten Jahren nicht unumstritten. Es gab Vorbehalte in der Gesellschaft, insbesondere in konservativen Kreisen, die den Sport als "unmännlich" oder "unproduktiv" ansahen. Auch die Infrastruktur war noch nicht so entwickelt wie heute. Es gab wenige richtige Fußballplätze, und die Vereine mussten oft improvisieren. Trotzdem hielten die Pioniere des deutschen Fußballs an ihrer Leidenschaft fest und trugen dazu bei, dass der Sport sich weiterentwickelte.

Der Fußball in den Weltkriegen und der Nachkriegszeit

Die beiden Weltkriege stellten auch für den deutschen Fußball eine Zäsur dar. Viele Spieler wurden eingezogen und fielen im Krieg. Der Spielbetrieb wurde stark eingeschränkt, und die Vereine mussten ums Überleben kämpfen. Nach dem Zweiten Weltkrieg lag Deutschland in Trümmern, und auch der Fußball musste sich neu erfinden. Es dauerte einige Zeit, bis sich der Spielbetrieb wieder normalisierte, aber der Fußball war ein wichtiger Faktor für den Wiederaufbau der deutschen Gesellschaft. Er bot den Menschen eine Möglichkeit, sich abzulenken, zusammenzukommen und Hoffnung zu schöpfen.

Die Nachkriegszeit war geprägt von der Teilung Deutschlands. In der Bundesrepublik Deutschland (BRD) entwickelte sich der Fußball weiter, während in der Deutschen Demokratischen Republik (DDR) ein eigenes Ligasystem entstand. Es gab zwar sportliche Kontakte zwischen den beiden deutschen Staaten, aber die politische Teilung prägte auch den Fußball. Ein besonders denkwürdiges Ereignis war die Fußball-Weltmeisterschaft 1974, bei der sich die BRD und die DDR in der Vorrunde gegenüberstanden. Die DDR gewann das Spiel überraschend mit 1:0, aber die BRD wurde am Ende Weltmeister.

Die Bundesliga und der moderne Fußball

Ein Meilenstein in der Geschichte des deutschen Fußballs war die Gründung der Bundesliga im Jahr 1963. Stellt euch vor, die besten Vereine Deutschlands spielen in einer einheitlichen Liga um die Meisterschaft! Das war ein wichtiger Schritt zur Professionalisierung des Fußballs und zur Steigerung seiner Popularität. Die Bundesliga entwickelte sich schnell zu einer der besten Ligen der Welt und zog zahlreiche Stars an. Vereine wie der FC Bayern München, Borussia Dortmund und der Hamburger SV prägten die Liga und sorgten für spannende Spiele und unvergessliche Momente.

Seit der Gründung der Bundesliga hat sich der deutsche Fußball stetig weiterentwickelt. Die Trainingsmethoden wurden professionalisiert, die Stadien modernisiert, und die Spieler wurden immer besser ausgebildet. Deutschland hat zahlreiche Erfolge auf internationaler Ebene gefeiert, darunter mehrere Weltmeistertitel und Europameistertitel. Der deutsche Fußball ist heute ein wichtiger Wirtschaftsfaktor und ein Exportschlager. Vereine wie der FC Bayern München sind weltweit bekannt und haben Millionen von Fans auf der ganzen Welt.

Fußball als Kulturgut und Reiseziel

Für mich ist der deutsche Fußball mehr als nur ein Sport. Er ist ein Kulturgut, das die Menschen verbindet und identitätsstiftend wirkt. Wenn ich durch deutsche Städte reise, spüre ich die Begeisterung für den Fußball überall. In den Kneipen und Biergärten werden die Spiele leidenschaftlich verfolgt, und die Fans feiern ihre Mannschaften ausgelassen. Ein Besuch eines Fußballspiels in Deutschland ist ein unvergessliches Erlebnis, das ich jedem Reisenden empfehlen kann.

Ich empfehle euch, bei eurer nächsten Deutschlandreise unbedingt ein Fußballspiel zu besuchen. Ob Bundesliga, 2. Bundesliga oder Regionalliga – die Stimmung in den Stadien ist einzigartig. Und vergesst nicht, das Deutsche Fußballmuseum in Dortmund zu besuchen, um mehr über die Geschichte des deutschen Fußballs zu erfahren. Ihr werdet begeistert sein!

Also, liebe Freunde, die Geschichte des deutschen Fußballs ist lang und bewegt. Sie beginnt im späten 19. Jahrhundert mit den ersten Vereinen und Pioniere, führt über die Weltkriege und die Teilung Deutschlands bis hin zur Gründung der Bundesliga und dem modernen Fußball. Der deutsche Fußball hat sich zu einem wichtigen Teil der deutschen Kultur entwickelt und ist ein Muss für jeden Reisenden, der das Land und seine Menschen kennenlernen möchte.

Auf geht's Deutschland, kämpfen und siegen! Und euch, liebe Reisende, viel Spaß beim Entdecken der deutschen Fußballkultur!